Составление семантического ядра с помощью сервиса Rush Analytics

Обзор сервиса составления семантического ядра Rush Analytics.

Те, кто хоть раз занимался составлением семантического ядра сайта, знают, что этот процесс является довольно затратным по времени. И если процесс сбора ключевых слов и их частотностей можно просто запустить в Key Collector, занимаясь своими делами, то группировку (кластеризацию) полученных запросов придется делать вручную.

Сервис Rush Analytics предоставляет следующие возможности:

- Сбор ключевых слов с помощью поисковых подсказок Яндекса и Google.

- Сбор ключевых слов с помощью Яндекс Wordstat.

- Сбор частотностей ключевых слов с помощью Яндекс Wordstat.

- Кластеризация ключевых слов.

Давайте рассмотрим весь функционал на реальном примере. Будем составлять семантическое ядро сайта про камины.

Цель данного обзора – разобраться с сервисом Rush Analytics, поэтому я просто прогоню ключевик “камины” через сервис и посмотрю результаты. В реальном проекте я бы провел мозговой штурм и анализ конкурентов, на основе этих данных набросал бы структуру сайта и начальные ключевые слова. Подготовил бы список минус слов, чтобы не парсить лишний мусор.

Сбор поисковых подсказок

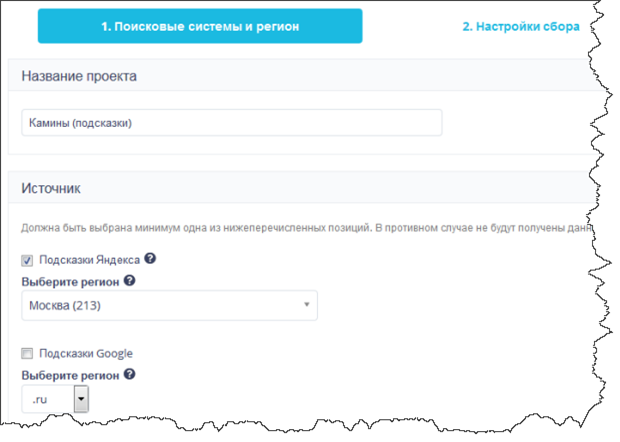

Поисковые системы и регион

Создаем проект для сбора подсказок.

Собирать подсказки будем с помощью Яндекса в регионе “Москва”. Если вы делаете проект для другого региона, то необходимо выбрать соответствующий вариант в выпадающем списке. Также, можно проводить сбор подсказок в Google (или в Яндексе и Google сразу).

Переходим к следующему шагу.

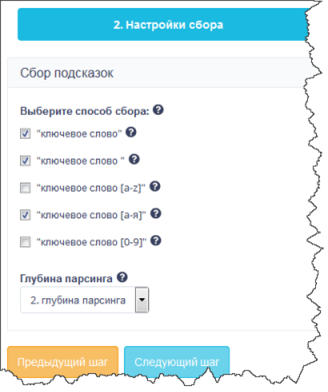

Настройки сбора

На этом шаге необходимо задать алгоритм сбора подсказок.

Первая опция – “ключевое слово”, означает, что будут собраны подсказки, выдаваемые поисковой системой при наборе заданных ключевых слов (на третьем шаге). Вторая опция – “ключевое слово “ – к ключевым словам добавляется пробел.

Три последних опции позволяют собирать подсказки по заданным ключевым словам, добавляя к ним через пробел символы латинского или русского алфавита, а также, цифры. Я буду использовать только буквы русского алфавита, но при составлении семантического ядра интернет магазина имеет смысл выбрать также латинские символы и цифры.

Глубина парсинга 2 означает, что сервис соберет поисковые подсказки для заданных на третьем шаге ключевых слов и полученный результат использует снова для сбора поисковых подсказок. Таким образом можно собрать большее количество слов.

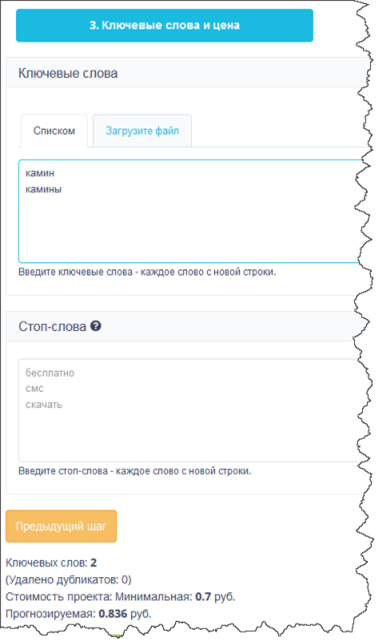

Ключевые слова и цена

На последнем шаге необходимо указать ключевые слова, по которым будет производиться сбор подсказок. Их можно ввести в поле или загрузить из excel файла.

Стоп слова позволяют отфильтровать нежелательные словосочетания и сэкономить бюджет. Например, если мы делаем информационный сайт про камины, то в стоп-словах можно указать “купить”. Если же мы составляем семантическое ядро для интернет магазина, то в стоп-слова надо записать “своими руками”, “чертежи” и т.п.

Внизу страницы указывается прогноз стоимости сбора подсказок. Цена сбора по одному варианту слова составляет всего 1 копейку. В нашем случае каждое ключевое слово создаст 35 вариантов (слово, слово + пробел, 33 * слово + пробел + буква русского алфавита). Т.е. минимальная стоимость для двух слов составит 70 копеек. Но так как указали глубину парсинга 2, то количество запросов будет намного выше. Прогнозируемая стоимость 0.836 руб. выглядит явно заниженной.

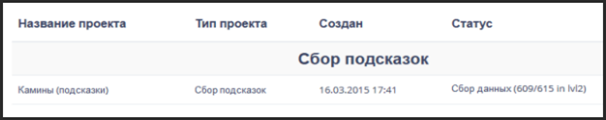

Создаем проект и запускаем его на выполнение. В зависимости от размера проекта и текущей загруженности, выполнение может занять от нескольких минут до нескольких часов. Текущее состояние отображается в списке проектов.

Результаты сбора поисковых подсказок

Спустя несколько минут процесс сбора поисковых подсказок завершился. Результат можно просмотреть в интерфейсе или загрузить в виде excel файла.

Из раздела финансовой статистики можно узнать, что было выполнено 685 запросов к подсказкам на сумму 6.85 рублей. Т.е. реальная стоимость оказалась выше прогнозируемой примерно в 8 раз (на 819% больше)!

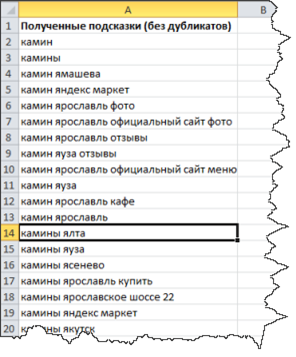

В Excel файле создается 3 страницы:

- Подсказки без дупликатов – содержит все собранные подсказки, дубли удалены.

- Все подсказки – содержит столбец с начальными словами, столбец с подсказками из первого парсинга и столбец с подсказками из второго парсинга.

- Настройки проекта – информация о настройках проекта, с которыми производился парсинг.

В моем случае было собрано 2554 уникальных поисковых подсказок.

К сожалению, в веб интерфейсе ключевые слова отображаются постраничным списком и с ними ничего нельзя сделать, кроме как просмотреть. Хотелось бы иметь возможность управлять собранными словами: удалять, фильтровать и т.п.

Сбор ключевых слов из Яндекс Wordstat

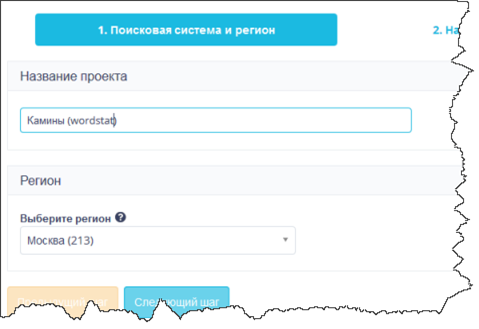

Регион проекта

Теперь соберем ключевые слова из Яндекс Wordstat. Для этого надо создать соответствующий проект и выбрать нужный регион.

К сожалению, опции “Все регионы” нет (в Яндекс Wordstat есть эта возможность). Но можно выбрать регион “Россия”, “СНГ (исключая Россию)” или другие страны.

Выбираем регион “Москва” и переходим к следующему шагу.

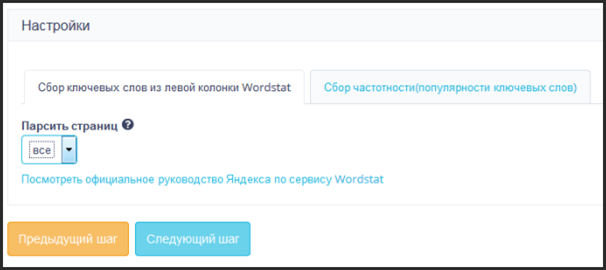

Настройки сбора

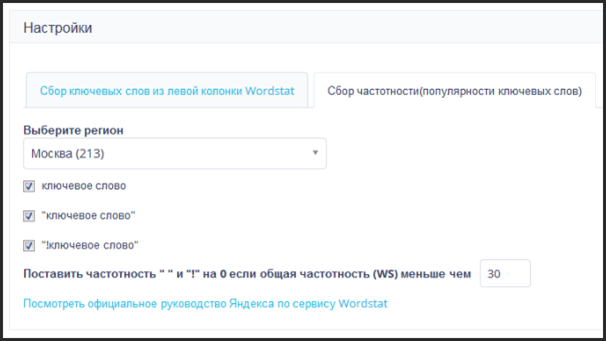

На этом шаге происходит выбор между сбором ключевых слов из левой колонки и сбором частотности. Сейчас мы будем собирать ключевые слова из левой колонки и остается только указать количество страниц Яндекс Wordstat, которые будут парситься.

Выбор “все” означает, что будет парситься 40 страниц, т.к. это максимальное количество Яндекс Wordstat.

Ограничивать парсинг по количеству страниц не совсем удобно. Обычно надо собрать все запросы с частотностью выше какого-то значения.

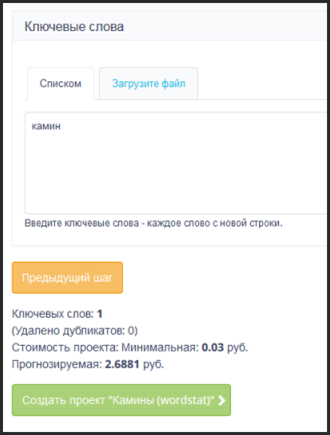

Ключевые слова

Наконец, на последнем шаге осталось указать ключевые слова, по которым будет выполняться парсинг Яндекс Wordstat.

Цена одного обращения к Яндекс Wordstat (парсинг одной страницы) составляет 3 копейки. По идее, сервис может распарсить максимум 40 страниц, т.е. максимальная стоимость должна быть равна 1.2 рубля. Но сервис почему-то прогнозирует 2.6 рубля.

После создания и запуска на выполнение, проект отправляется в очередь и через некоторое время начинается сбор данных.

Результаты сбора ключевых слов из Яндекс Wordstat

В результате парсинга получилось 2000 ключевых слов (списано 1.2 рубля). Их можно посмотреть в веб интерфейсе или скачать в Excel файле.

Сбор частотностей из Яндекс Wordstat

Настройки сбора

Для сбора частотностей надо создать такой же проект, как для сбора слов из левой колонки, но на втором шаге выбрать вкладку “Сбор частотности”.

Будем собирать все виды частотностей. Последняя настройка позволяет экономить бюджет и не собирать частотности для ключевых слов с низким значением общей частотности.

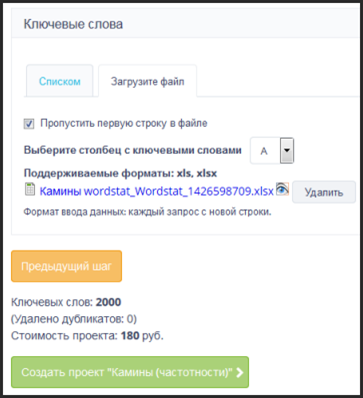

Ключевые слова и цена

Теперь надо загрузить ключевые слова. Используем ключевые слова, собранные из левой колонки Wordstat.

Интересно, что слова, собранные из поисковых подсказок можно сразу отправить на сбор частотностей, а слова из Wordstat приходится загружать из файла.

Как и в предыдущем случае, одно обращение к Яндекс Wordstat стоит 3 копейки. Но для сбора частотностей требуется делать запрос для каждого слова. Поэтому сбор частотностей для 2000 слов будет стоить целых 180 рублей (2000 * 3 * 0.03 р.).

Key Collector рекомендует собирать частотности через Яндекс Директ: это намного быстрее, а вероятность бана низка.

Я думаю, что Rush Analytics также использует этот способ, но тарифицирует его как обращение к Яндекс Wordstat.

Со мной связался предстаитель Rush Analytics и уверил, что для сбора частотности используется именно Яндекс Wordstat.

Кластеризация (группировка) ключевых слов

Это, пожалуй, одна из самых интересных и полезных возможностей сервиса. Ведь обычно эту работу приходится выполнять вручную и при большом количестве ключевых слов это занимает очень много времени.

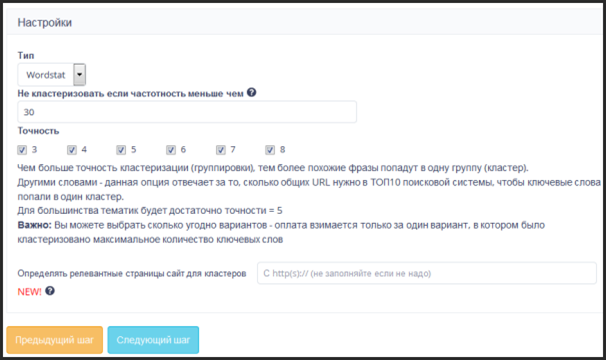

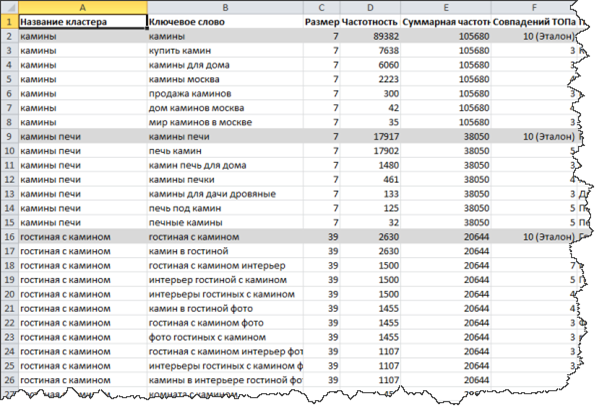

Как работает кластеризация? Сервис выполняет сбор топ 10 сайтов по каждому ключевому слову. Если по нескольким словам в выдаче присутствуют несколько (число задается в настройках проекта) одних и тех же страниц, то эти запросы объединяются в группу.

Параметр “Точность” задает минимальное количество совпадений, при которых слова попадают в один кластер.

Дополнительно можно указать сайт, у которого будут подобраны релевантные страницы для каждого кластера.

Стоимость кластеризации вычисляется довольно сложно. Каждая проверка выдачи стоит 2.5 копейки. Т.е. проверка 2000 слов обойдется в 50 рублей. Плюс, сервис снимает 85 копеек за каждый сгруппированный запрос. Кластеризация моих слов стоила 576 рублей.

В результате я получил шесть excel файлов с кластеризированными запросами.

Группировка сделана очень неплохо. Понятно, что лучшее качество обеспечивает ручная работа, но если времени нет, то результаты работы сервиса можно использовать для создания структуры сайта и составления списка статей. Другое дело, что надо было вручную почистить многие запросы перед кластеризацией.

Для точности=3 сервис сделал 308 кластеров, содержащих 1152 запроса. К сожалению, большая часть кластеров содержит только 2 элемента. Мне бы хотелось иметь возможность задавать в настройках минимальный размер кластера.

Для точности=8 получилось 102 кластера с 222 запросами.

В целом функционал кластеризации мне понравился, но его стоимость мне кажется завышенной. Кроме того, хотелось бы в веб интерфейсе иметь сводную информацию: сколько запросов кластеризировано по каждой точности, количество запросов из двух, трех и т.д. элементов.

Если вас интересуют способы группировки ключевых слов, то рекомендую почитать обзор 15 инструментов для кластеризации запросов при составлении семантического ядра.

Служба поддержки

Общение со службой поддержки организовано через сторонний сервис userecho.com. Хоть он и интегрирован в сайт Rush Analytics, но для общения с поддержкой придется завести аккаунт еще в одном сервисе. К тому же, очень непривычно, что залогинившись в админку одного сервиса (Rush Analytics), мне надо еще логиниться ко второму (userecho).

Тем не менее, в остальном работа через сторонний сервис проблем не вызывает. Сама служба поддержки отвечает достаточно оперативно и по делу. Мне приходили ответы даже поздно вечером.

Итог

Сервис Rush Analyticsоткрылся недавно и пока содержит не очень много возможностей. Самой полезной функцией является кластеризация, но этот функционал является и самым дорогим.

Минусы:

- сторонний сервис для обратной связи

- высокая цена кластеризации

- мелкие недоработки

- ограниченный функционал

Плюсы:

- простота

- высокая скорость работы

В целом сервис мне понравился и я буду с нетерпением ждать появления нового функционала. Очень понравилось, что по каждой возможности есть подробная справка и видео-обзор.

Недавно анонсированы новые возможности, которые в данный момент находятся в тестировании:

- Пакетная проверка индексации страниц

- Модуль анализа конкурентов

- Мощный парсер позиций с фееричным функционалом

Мне бы хотелось еще как минимум иметь возможность собирать данные для расчета KEY (конкуренция в ПС, вхождение слов в тайтлы топ 10 и т.п.). Без этого я не могу отказаться от Key Collector.

Related Posts

Сервис подбора домена для рунета

Полезный сервис для подбора имени домена, работающий с зоной .ru

Обзор сервиса проверки позиций vaddox.com

Обзор еще одного сервиса проверки позиций сайта с расширенным функционалом.