Сбор семантического ядра с помощью сервиса keys.so

Обзор сервиса keys.so на примере сбора семантического ядра информационного сайта.

В начале ноября состоялся запуск сервиса keys.so, предназначенного для подбора ключевых слов на основе анализа сайтов конкурентов. Его создатели собрали около 140 миллионов ключевых слов из разных источников, проверили их частотность по Яндекс вордстату и оставили только ключи с частотностью выше 30. В результате осталось чуть больше 42 миллионов ключевых слов.

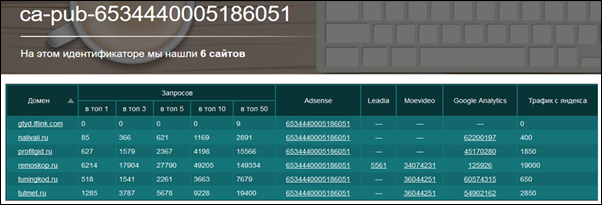

По каждому ключу были собраны сайты из топ 50 выдачи Яндекса. Таким образом, сервис знает все ключи, по которым сайт находится в топ 50. Также, с каждого сайта были просканированы 10-20 страниц, чтобы получить информацию по идентификаторам систем рекламы и аналитики (Google Adsense, Google Analytics и других), по которым можно легко определить сайты одного владельца.

Обзор возможностей сервиса

Давайте рассмотрим возможности сервиса на примере. Предположим, мы хотим сделать информационный сайт в теме строительства. Для этого необходимо выбрать нишу и собрать семантическое ядро. Процесс сбора СЯ довольно трудоемкий: надо собрать ключевые слова, определить их частотности, сгруппировать. Но с помощью keys.so все это можно сделать в течение нескольких минут.

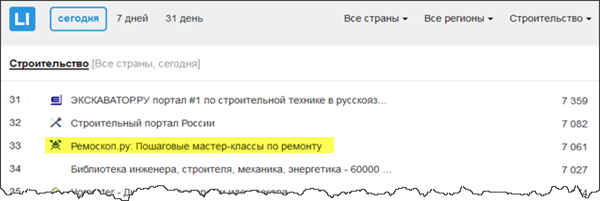

Идем на liveinternet.ru/rating/, выбираем категорию “строительство” и ищем подходящих конкурентов.

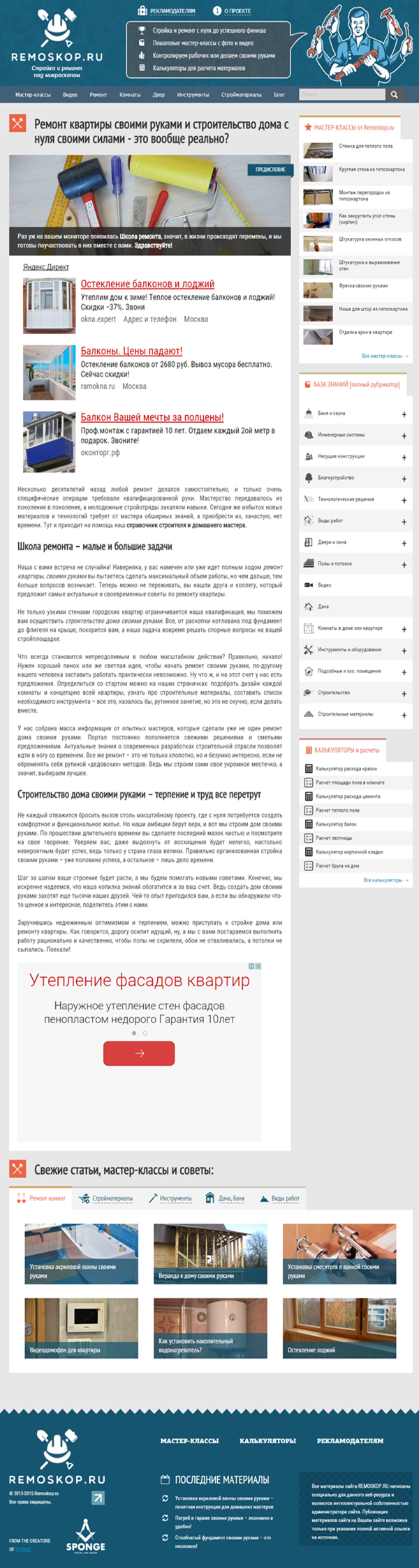

Мне приглянулся сайт Ремоскоп.ру. Сделан он очень качественно и может служить хорошим примером информационного сайта для заработка на контекстной рекламе.

Сводная информация сайта

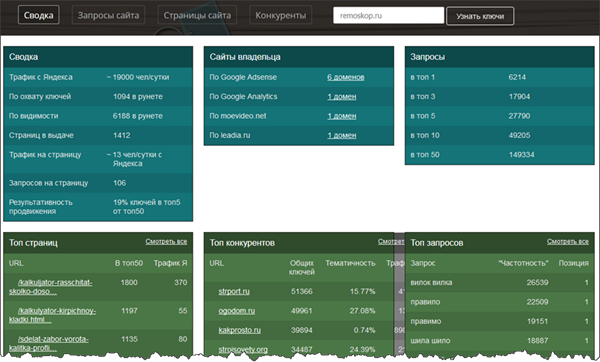

Вставляем url в keys.so и получаем сводную информацию по сайту:

Эти данные доступны без регистрации.

Сводный отчет содержит шесть блоков. Рассмотрим каждый из них подробнее.

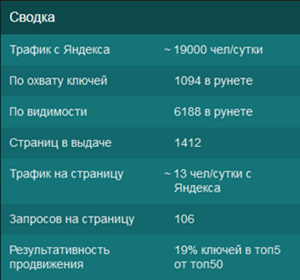

Сводка

В этом блоке отображается сводная информация о трафике и ключах сайта. Данные по трафику с Яндекса довольно приблизительные: в некоторых случаях цифра близка к реальности, а в некоторых отображаются совсем неверные данные.

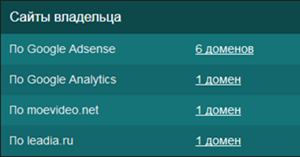

Сайты владельца

Здесь видно, сколько сайтов есть с такими же идентификаторами систем рекламы и аналитики. По Google Adsense мы можем спалить еще 5 сайтов этого владельца:

Как можно использовать эту информацию? Если вы не определились с нишей, то можно подчерпнуть новые идеи. Особой пользы я больше не вижу, разве что хочется насолить кому-то.

Некоторые блогеры рассказывают о продвижении или монетизации своих сайтов без указания конкретных url. С помощью этого сервиса в некоторых случаях можно найти сайты, о которых идет речь и получать более полную информацию.

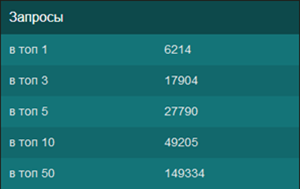

Запросы

В этом блоке просто показано количество запросов сайта, попавших в топы Яндекса.

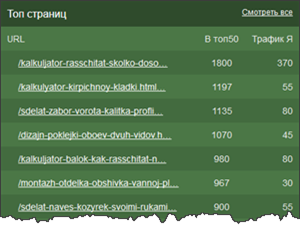

Топ страниц

Этот и следующие три блока отображают первые 20 строк основных отчетов сервиса.

Здесь показываются страницы, имеющие видимость по наибольшему количеству ключевых слов.

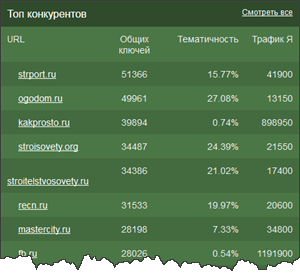

Топ конкурентов

Сайты, присутствующие в топ 50 Яндекса по тем же ключевым словам. Часто в первых строках этого отчета отображаются общетематические сайты, собирающие трафик по очень большому количеству ключевиков. Отобрать реальных конкурентов помогает столбец “Тематичность”, показывающий процент совпадения тематики сайтов.

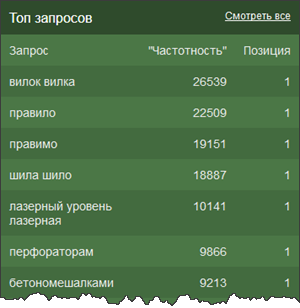

Топ запросов

Этот блок показывает запросы, по которым сайт занимает первые позиции в поиске.

Теперь рассмотрим полные отчеты по сайту. Для этого необходима регистрация и оплата тарифного плана.

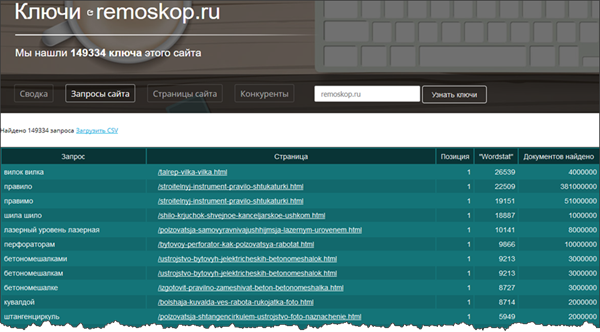

Запросы сайта

Это, на мой взгляд, самый полезный отчет. Совершенно без труда мы только что получили 149 тысяч запросов для сайта по теме ремонта. Причем, у нас есть сразу частотность в кавычках по вордстату. А сгруппировав запросы по странице, мы автоматически получим группы ключевых слов.

Проводить анализ ключевых слов удобнее в Excel, скачав данные в формате CSV.

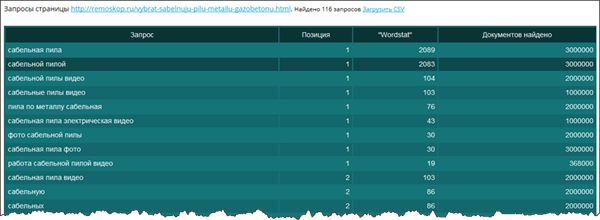

При клике по странице можно увидеть все запросы, по которым эта страница находится в топе:

Повторю, что эту же информацию можно получить в Excel, скачав данные по всем запросам сайта.

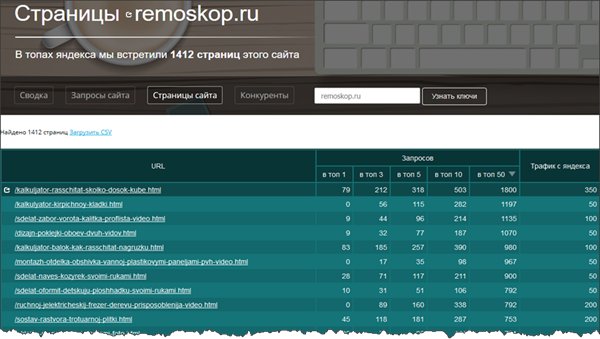

Страницы сайта

Здесь видно, по скольким запросам каждая страница находится в топах и примерный трафик с Яндекса.

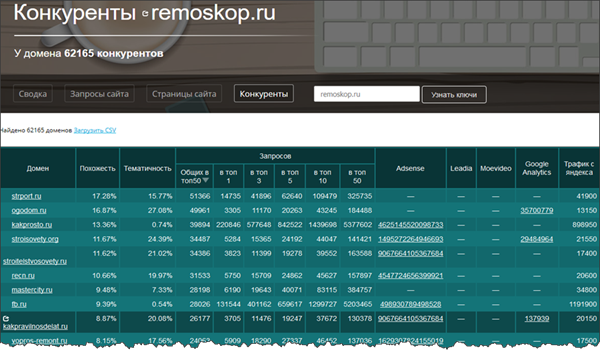

Конкуренты

Полный отчет по сайтам, находящимся в топ 50 по ключевым словам анализируемого сайта. С этого отчета можно сразу перейти к анализу сайта конкурента или посмотреть другие сайты с такими же идентификаторами систем рекламы и аналитики.

Для удобства анализа надо добавить к идентификатору (или вместо него) количество сайтов.

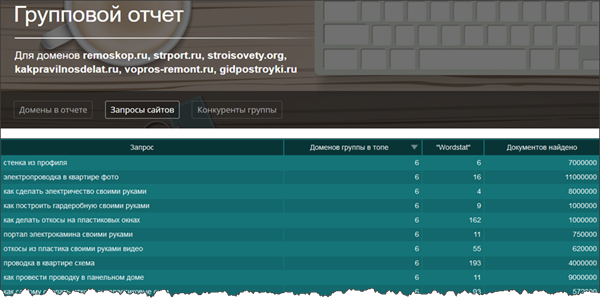

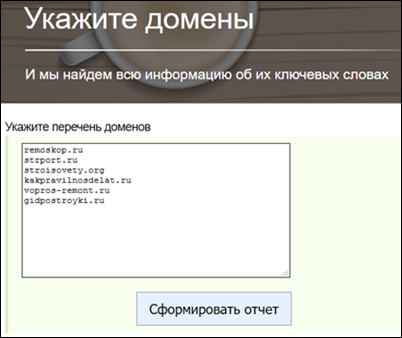

Групповые отчеты

С помощью функции “Групповые отчеты” можно собирать ключевые слова сразу по нескольким сайтам. Возьмем для примера еще несколько конкурентов Ремоскоп.

После нажатия кнопки “Сформировать отчет” начнется процесс подготовки данных, который может занять до пяти минут.

Честно говоря, этот отчет меня разочаровал: нет информации, какие сайты и страницы попадают в топ по каждому запросу. Понятно, что для вывода такой информации потребуется усложнить пользовательский интерфейс. Но без этого теряется возможность автоматической группировки ключевых слов.

В текущем виде информация из этого отчета поможет выбрать самые тематические ключевые слова. Для этого надо собрать побольше конкурентов и выбрать только общие для них запросы.

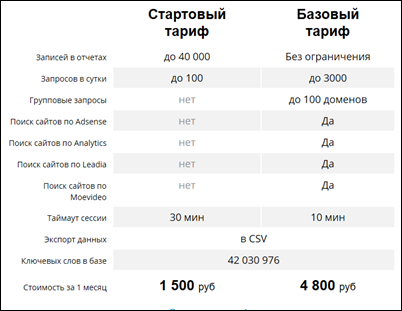

Тарифы

Создатели сервиса предлагают всего два тарифных плана: стартовый и базовый. Причем, как следует из названия, основным является базовый тариф, а возможности стартового ограничены.

Еще кейсы

Сетка Пузата

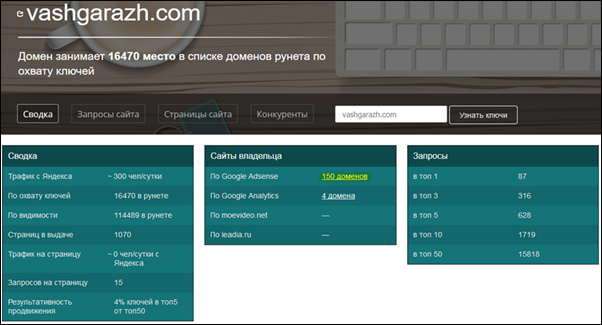

А давайте посмотрим все сайты Пузата! В своем марафоне он рассказывает про vashgarazh.com и jlady.ru. Смотрим:

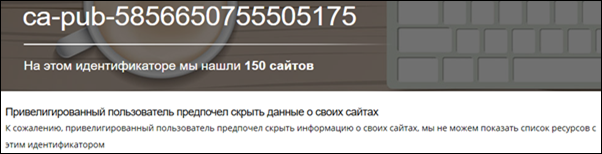

Ого! У Пузата целых 150 сайтов! Интересно посмотреть на них:

Упс! Облом ![]() . Очевидно, Пузат договорился с создателями сервиса, чтобы его сайты не палили.

. Очевидно, Пузат договорился с создателями сервиса, чтобы его сайты не палили.

Расширение семантического ядра

При составлении СЯ классическим методом (с помощью вордстата) мы ограничены начальным набором высокочастотных ключевых слов. Например, если мы хотим сделать сайт про Париж, то соберем весь вордстат со словом “париж”, затем добавим “Эйфелеву башню”, “Лувр” и другие известные достопримечательности.

Но при этом все равно упустим много хороших ключевиков, не содержащих этих слов. С помощью keys.so необходимо лишь найти несколько конкурентов и можно легко найти дополнительные ключи.

Увеличение трафика на собственный сайт

Помните отчет “Страницы сайта”? А что если выбрать страницы, присутствующие в топ 50, но отсутствующие в топ 10 и заняться их оптимизаций? При этом, ориентироваться стоит на самые частотные запросы.

Итог

Сервис keys.so во многом похож на хорошо известные Prodvigator (обзор) и SemRush (обзор), но имеет свою изюминку в виде показа сайтов одного владельца. Кроме того, создатели сервиса утверждают, что собрали самую большую базу ключевых слов.

Несмотря на то, что сервис еще совсем молодой и содержит некоторые баги, а интерфейс далек от совершенства, свою главную задачу (сбор семантического ядра) он выполняет отлично.

Преимущества сервиса:

- большой объем ключевых слов (42 миллиона)

- сбор СЯ за несколько минут

- возможность увидеть сетки сайтов

- высокая скорость работы (кроме группового отчета)

Недостатки сервиса:

- неправильные данные по сайтам, работающим по протоколу https (обещают исправить в следующем апдейте)

- данные через некоторое время устаревают (как часто будут производиться апдейты пока неизвестно)

- привилегированные пользователи (Пузат)

- нет API (для автоматизации)

- нет выбора региона

- относительно высокая цена

Что можно улучшить:

- в конкурентах добавить количество сайтов с одинаковым идентификатором

- расширить групповой отчет

- добавить возможность фильтрации и группировки ключевых слов в интерфейсе (сейчас для обработки и анализа данных необходим Excel)

- сделать расчет KEY по каждому запросу (есть частотность, количество документов и страница сайта, надо собирать еще хотя бы title каждой страницы из выдачи)

Related Posts

Спираль истории или вечные ссылки

Заменят ли вечные ссылки ставшие уже привычными ссылки с помесячной оплатой.

Проверка позиций сайта: новый мега обзор

Новый обзор сервисов проверки позиций в серпе поисковиков.